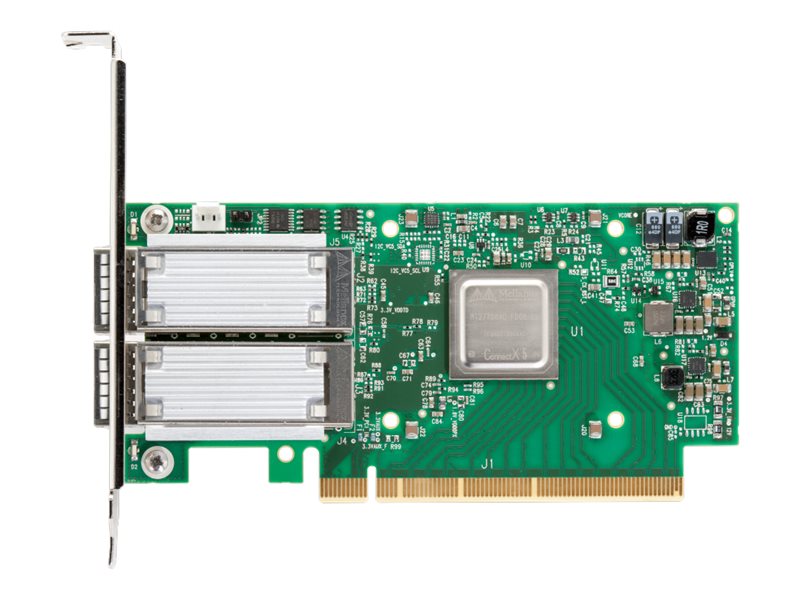

Mellanox NVIDIA ConnectX-5 Ex EN - Netzwerkadapter - PCIe 4.0 x16

Artikel anbieten

Sie möchten uns diesen Artikel anbieten? Dann füllen Sie bitte das Formular aus.

Artikelnummer:

MCX516A-CDAT

EAN:

7290108480399

Produktinformationen "Mellanox NVIDIA ConnectX-5 Ex EN - Netzwerkadapter - PCIe 4.0 x16"

NVIDIA ConnectX-5 InfiniBand-Adapterkarten bieten eine leistungsstarke und flexible Lösung mit bis zu zwei InfiniBand- und Ethernet-Anschlüssen, niedriger Latenz und hoher Nachrichtenrate sowie einem integrierten PCIe-Switch und NVMe over Fabrics Offloads. Diese intelligenten, RDMA-fähigen (Remote Direct Memory Access) Adapter bieten erweiterte Anwendungs-Offload-Funktionen für High-Performance Computing (HPC), Cloud Hyperscale und Speicherplattformen.

ConnectX-5-Adapterkarten für PCIe Gen 3 und Gen 4 Server sind als Stand-up-PCIe-Karten und Open Compute Project (OCP) Spec 3.0-Formfaktoren erhältlich. Ausgewählte Modelle bieten auch NVIDIA Multi-Host und NVIDIA Socket Direct Technologien.

ConnectX-5-Adapterkarten für PCIe Gen 3 und Gen 4 Server sind als Stand-up-PCIe-Karten und Open Compute Project (OCP) Spec 3.0-Formfaktoren erhältlich. Ausgewählte Modelle bieten auch NVIDIA Multi-Host und NVIDIA Socket Direct Technologien.

- HPC-Umgebungen

ConnectX-5 bietet Verbesserungen für HPC-Infrastrukturen durch die Bereitstellung von MPI- und SHMEM/PGAS- und Rendezvous-Tag-Matching-Offload, Hardwareunterstützung für RDMA-Schreib- und Lesevorgänge außerhalb der Reihenfolge sowie zusätzliche Unterstützung für atomare Netzwerk- und PCIe-Atomoperationen. ConnectX-5 erweitert die RDMA-Netzwerkfähigkeiten durch die Vervollständigung der adaptiven Routing-Funktionen des Switches und die Unterstützung von Daten, die außer der Reihe geliefert werden. Dabei wird die Semantik der geordneten Vervollständigung beibehalten, und es werden Multipath-Zuverlässigkeit und effiziente Unterstützung für alle Netzwerktopologien, einschließlich DragonFly und DragonFly+, geboten. ConnectX-5 unterstützt außerdem Burst-Buffer-Offload für Checkpointing im Hintergrund, ohne die Haupt-CPU-Operationen zu beeinträchtigen, sowie den innovativen DCT-Service (Dynamic Connected Transport), der extreme Skalierbarkeit für Compute- und Storage-Systeme gewährleistet. - Speicherumgebungen

NVMe-Speichergeräte werden immer beliebter und bieten einen sehr schnellen Speicherzugriff. Das NVMe over Fabrics (NVMe-oF)-Protokoll nutzt RDMA-Konnektivität für den Fernzugriff. ConnectX-5 bietet weitere Verbesserungen durch die Bereitstellung von NVMe-oF-Ziel-Offloads, die einen hocheffizienten NVMe-Speicherzugriff ohne CPU-Eingriff und damit eine verbesserte Leistung und geringere Latenz ermöglichen. Standard-Block- und Dateizugriffsprotokolle können RDMA für den Hochleistungsspeicherzugriff nutzen. Ein konsolidiertes Rechen- und Speichernetzwerk bietet im Vergleich zu Multi-Fabric-Netzwerken erhebliche Kosten- und Leistungsvorteile. - Adapterkarten-Portfolio

ConnectX-5 InfiniBand-Adapterkarten sind in verschiedenen Formfaktoren erhältlich, darunter Low-Profile-Standup-PCIe, Open Compute Project (OCP) Spec 3.0. Mit der NVIDIA Multi-Host-Technologie können mehrere Hosts an einen einzigen Adapter angeschlossen werden, indem die PCIe-Schnittstelle in mehrere unabhängige Schnittstellen aufgeteilt wird. Das Portfolio bietet auch NVIDIA-Socket-Direktkonfigurationen, die es Servern ohne x16-PCIe-Steckplätze ermöglichen, den 16-Lane-PCIe-Bus der Karte in zwei 8-Lane-Busse auf dedizierten Karten aufzuteilen, die über einen Kabelbaum verbunden sind. Dies ermöglicht auch Servern ohne x16-PCIe-Steckplatz eine Port-Geschwindigkeit von 100 Gb/s. Socket direct ermöglicht auch NVIDIA GPU Direct RDMA für alle CPU/GPU-Paare, indem sichergestellt wird, dass alle GPUs mit CPUs in der Nähe der Adapterkarte verbunden sind, und ermöglicht Intel DDIO auf beiden Sockeln, indem eine direkte Verbindung zwischen den Sockeln und der Adapterkarte hergestellt wird.

Allgemein

Gerätetyp

Netzwerkadapter

Formfaktor

Plug-in-Karte

Schnittstellentyp (Bustyp)

PCI Express 4.0 x16

PCI-Spezifikationsrevision

PCIe 1.1, PCIe 2.0, PCIe 3.0, PCIe 4.0

Netzwerk

Ports

100 Gigabit QSFP28 x 2

Anschlusstechnik

Kabelgebunden

Data Link Protocol

100 Gigabit Ethernet

Datenübertragungsrate

100 Gbps

Netzwerk/Transportprotokoll

TCP/IP, UDP/IP, SMB, NFS

Leistungsmerkmale

Auto-Negotiation, MPLS-Unterstützung, QoS, RDMA-Unterstützung, PXE-Unterstützung, LSO, LRO, RSS, UEFI-Support, AER, Unterstützung von Prüfsummen-Offload, MSI-X, iSCSI remote boot, HDS, TSS, RoCE, PFC, NC-SI, VXLAN, NVGRE, TPH, XRC transport, DCT, UMR, ODP, Mellanox PeerDirect, MSI, OVS Offload, DPDK, Jumbo Frame-Unterstützung (bis zu 9600 Bytes), VLAN Tagging, ASAP, MCTP over SMBus, DPC, ACS, PASID, ATS, ETS, QCN, GENEVE-Support, Multi-Host-Technologie, Open Compute Project (OCP) 3,0 Unterstützung

Produktzertifizierungen

IEEE 802.1Q, IEEE 802.1p, IEEE 802.3ad (LACP), IEEE 802.3ae, IEEE 802.3ap, IEEE 802.3az, IEEE 802.3ba, IEEE 802.1AX, IEEE 802.1Qbb, IEEE 802.1Qaz, IEEE 802.1Qbg, IEEE 1588v2, IEEE 802.3bj, IEEE 802.3bm, IEEE 802.3by, OCP 3.0

Erweiterung/Konnektivität

Schnittstellen

2 x 100Gb Ethernet - QSFP28

Verschiedenes

Kennzeichnung

RoHS

Software / Systemanforderungen

Erforderliches Betriebssystem

FreeBSD, Microsoft Windows, Red Hat Enterprise Linux, CentOS, VMware ESX

Anmelden